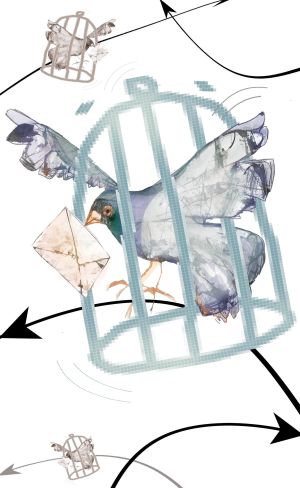

Amordazados por los robots informáticos

La digitalización de nuestra vida pública está dando lugar a nuevos mediadores. en la Red hay multitud de mecanismo de planificación insidiosa en manos de la publicidad o la censura. Debemos mantenerlos a raya

EULOGIA MERLE

Pongamos por caso los blogs. Cuando la primera generación de blogueros entró en la Red, los únicos intermediarios con los que se encontraban eran su entidad anfitriona y su proveedor de servicios de Internet. Cualquiera que empiece un blog en 2012 probablemente irá a parar a una plataforma comercial como Tumblr o Word Press, y con los comentarios a su blog encauzados por un tercero, por ejemplo una compañía como Disqus. La propia Disqus, además, colabora con una empresa llamada Impermium, que cuenta con diversas herramientas automáticas que comprueban si los comentarios enviados son spam. Es la proliferación, no la eliminación, de intermediarios lo que ha hecho del blogging algo tan extendido; aquí el término adecuado es “hiperintermediación”, no “desintermediación”.

Impermium, además, sostiene haber desarrollado una tecnología capaz de “identificar no solo el spam y los vínculos maliciosos, sino también todo tipo de contenidos dañinos —tales como violencia, racismo, irreverencia flagrante e incitación al odio—, que permite a los propietarios actuar contra ellos en tiempo real, antes de que llegue a los lectores”. Afirma tener a 300.00 páginas web como clientes. Así es: una sola empresa californiana está tomando decisiones sobre qué se considera incitación al odio y qué se considera irreverencia para 300.000 sitios.

El modelo de Impermium es interesante porque añade una capa de big data (sistemas que manejan grandes conjuntos de datos) al proceso de tachar algo como spam o como incitación al odio. Solía suceder que cualquiera que mencionase Viagra en su comentario o en su entrada de blog sería bloqueado inmediatamente; Impermium afirma que haciendo uso de los datos de usuario que le llegan de su red de 300.000 sitios web en los que participa, puede realmente distinguir las bromas sobre Viagra del spam sobre Viagra.

Eso podría parecer liberador. En otros contextos, sin embargo, ese matrimonio entre big data y moderación automática de contenidos podría tener un lado más oscuro, en particular en los regímenes no democráticos, para los que una guerra al spam es tan solo un pretexto para suprimir las opiniones disidentes.

Los blogueros de China, por ejemplo, emplean regularmente eufemismos y alusiones para hacerles trampa a sus censores algorítmicos. Una expresión aparentemente inocua como “cangrejo de río” suele querer significar “censura de Internet”, en tanto que “terapia vacacional” se ha utilizado para referirse a detenciones de autoridades del Gobierno. Dejadas sin censurar tales expresiones se convierten rápidamente en memes (unidades mínimas de información cultural transmisible), desencadenando debates críticos sobre la política china.

Con la ayuda de los big data, el software de filtración de contenidos puede comprobar la frecuencia relativa con la que tales expresiones son utilizadas en otros sitios populares e investigar qué comentadores las utilizan realmente para descubrir eufemismos sospechosos. O podrían investigar de qué puntos geográficos proceden algunas de esas entradas: imaginen qué tipo de posibilidades censoras se abrirán una vez que las decisiones moderadoras puedan incorporar información sobre localización espacial: ¿Por qué no bloquear comentarios, vídeos o fotos cargados por usuarios situados en, digamos, la plaza de Tahrir o en algún otro lugar políticamente explosivo?

En el seguimiento de las revueltas de la primavera árabe, cualquiera que introdujera en Twitter comentarios críticos sobre Bahréin o Siria es probable que recibiera airadas correcciones de los leales al Gobierno o, más probablemente aún, de sus bots (robots informáticos). Asimismo, los activistas tibetanos lamentan que varias etiquetas de Twitter relacionadas con Tíbet tienen tanta propaganda creada por spambots (robots portadores de spam) que han conseguido inutilizarlos.

Para los Gobiernos, la próxima frontera es la de aprender a identificar, adelantarse y desbaratar posibles memes emergentes. Así, una de las agencias de seguridad rusas ha adjudicado recientemente un concurso para crear robots informáticos que pueden tanto reconocer la formación de memes como trastocarlos y contrarrestarlos en tiempo real mediante “la distribución masiva de mensajes en las redes sociales con vistas a la formación de la opinión pública”. Aquí Moscú está aprendiendo de Washington: el año pasado el Pentágono adjudicó un contrato a una empresa de San Diego para la producción de un software para crear múltiples identidades falsas en la Red y “contrarrestar la propaganda enemiga extremista y violenta fuera de Estados Unidos”.

El PRI fue acusado de manipular la Red para lograr convertir en un 'trending topic' un mensaje preestablecido

En segundo lugar, los bots pueden añadir lastre numérico a los memes que ya han sido promovidos por humanos prominentes con el fin de situarlos a la cabeza del ranking de virus. Durante las elecciones presidenciales mexicanas de este año, el PRI (cuyo candidato ganó la elección) fue acusado de programar miles de bots para enviar tuits con palabras y frases específicas con objeto de hacer aparecer un mensaje preestablecido en los trending topics de Twitter.

En tercer lugar, los bots más sofisticados pueden cumplir otra función muy interesante: pueden hacer que unos humanos se presenten el uno al otro, por ejemplo mencionando en un mismo tuit sus respectivos nombres de usuarios de Twitter. Un experimento hecho en 2011 por PacSocial, una empresa de analítica centrada en los bots, reveló que estos, de hecho, pueden hacer aumentar las conexiones entre usuarios. Así que, con tan solo algunas manipulaciones inteligentes, los bots pueden hacer que sigas a los humanos adecuados, y son los humanos, no los bots, los que luego influirán en tu manera de pensar.

La digitalización hará que aumente —¡no que disminuya!— el número de mediadores en nuestra vida pública. No hay nada intrínsecamente malo en los intermediarios mientras nos acordemos de mantenerlos a raya. De ese modo, en vez de celebrar el mítico nirvana de la desintermediación, deberíamos esforzarnos por ver el interior de las cajas negras de los algoritmos del spam y de los bots propagandísticos. Puede que nuestro debate público no esté a la altura de nuestros memes, pero no deberíamos olvidar que no todos son creados iguales: algunos ni siquiera son creados, mientras que otros son producto de considerables dosis de astuta e insidiosa planificación.

Evgeny Morozov es profesor

visitante en la Universidad de Stanford y profesor en la New America

Foundation. Su último libro publicado en España es El desengaño de Internet. Los mitos de la libertad en la Red (Destino).

No hay comentarios:

Publicar un comentario